L'équipe Adelean est de retour de la conférence Devoxx France 2024, la grande conférence des développeurs et développeuses, placée cette année sous le signe de l'intélligence artificielle generative.

L'édition 2024 de Devoxx France a eu lieu du 17 au 19 avril à Paris et a accueilli 4500 visiteurs uniques par jour sur 3 jours et 5500 m² d’exposition

Devoxx est une conférence technique, destinée aux développeurs et développeuses, avec des franchises dans plusieurs pays. Devoxx France est d’abord un ensemble de conférences et ensuite un salon classique avec stands et exposants. Ce qui fait l’ADN de Devoxx, c’est l’importance donnée au contenu : cette année pour la conférence de Paris, 1129 propositions de presentation ont été reçues sur le site du CFP (call for papers) dont seulement 278 ont été acceptées.

L'équipe Adelean a eue la chance d'être séléctionnée pour cinq interventions ainsi que pour animer un Bird of Feather ou BoF, une session de discussions informelles et spontanées. La conférence a été également l’occasion d’assister à des presentations passionnantes, de rencontrer d’autres orateurs, participants, partenaires et clients, de découvrir les dernières tendances et technologies et de partager des moments de convivialité.

Les conférences avaient plusieurs formats (Hands-on Lab, Conférence, Deep Dive, Keynote, Lunch Talk et Tools-in-Action) et couvraient plusieurs thèmes : Architecture, Build & Deploy, Data & AI, Development & Langages, Java, Mind the geek, People & Culture, Security, Server Side, UI & UX. En marge des conférences plusieurs événements ont été organisés en fin de journées : mercredi - le speaker dinner et jeudi - la soirée meet & greet. Nous tenons à saluer une programmation parfaite, une agenda très riche, une organisation sans faille et une équipe organisatrice (les gilets rouges) au top.

Voici la liste complète des ateliers Adelean. Nous partagerons également les vidéos lorsqu’elles seront disponibles en ligne.

Malgré notre agenda très chargé par les conférences et ateliers que nous avons animés, nous avons eu l’occasion de participer à quelques présentations. Je fais ici un retour sur les conférences auxquelles j’ai pu personnellement participer, nous ferrons un retour sur les autres présentations qui nous ont marquées dans des prochains articles. Puis je citerais les conférences que j’aurais aimé suivre et que je vais regarder en replay.

Lien de la conférence : Tout ce que vous n’avez jamais voulu savoir sur les fuseaux horaires

J’ai apprécié la forme de cette conférence. Julien Deniau a su captiver son audience en nous racontant des anecdotes sur les fuseaux horaires. Il a commencé par nous expliquer pourquoi il a choisi ce sujet (notamment pour comprendre le “pourquoi” des problèmes qu’il a rencontré), puis il a enchainé avec des exemples concrets, très bien documentés et des histoires drôles. J’ai appris de choses sur les fuseaux horaires et j’ai passé un très bon moment.

Mon take-away de cette conférence : “Les fuseaux horaires sont un casse-tête, mais maintenant nous savons pourquoi”. Plus sérieusement, j’ai retenu que les fuseaux horaires sont un problème complexe, que les standards sont nombreux ou n’existent parfois tout simplement pas et que les règles changent souvent. Sur le côté pratique, il est toujours mieux de sauvegarder les dates et heures en UTC et de les convertir en temps local au moment de l’affichage ou de leur restitution par API.

Lien de la conférence : Crafting your own RAG system: Leveraging 30+ LLMs for enhanced performance

Pour permettre au public international de suivre la conférence, les organisateurs se sont assurés qu’au moins un talk en anglais a lieu par créneau. J’avais déjà vu une intervention de Stephan Janssen à Devoxx UK en 2023 et je savais que cette conférence était un must. En plus elle était classée dans le thème Data & AI, thème que j’ai particulièrement suivi.

Stephan a fait quelques annonces en prémière : il a annoncé la publication de son code utilisé pour la conférence en open source : RAG Genie ainsi que la sortie du plugin IntelliJ IDEA : Devoxx Genie.

RAG Genie est un prototype LLM RAG pour tester et évaluer vos embeddings, vos stratégies de découpage en morceaux en utilisant des questions-réponses et des évaluations.

Devoxx Genie est un plugin LLM entièrement basé sur Java pour IntelliJ IDEA, conçu pour s’intégrer avec des fournisseurs LLM locaux tels que Ollama, LMStudio et GPT4All, mais aussi avec des LLM basés sur le cloud tels que OpenAI, Anthropic, Mistral, Groq et bien d’autres. Ce plugin facilite la révision, le test et l’explication du code de votre projet, améliorant ainsi votre flux de développement.

Comme à Devoxx UK, la conférence était très dense, technique et bien agrémentée d’exemples concrets. Au passant, nous avons appris qu’il y a beaucoup de weekend pluvieux en Belgique (propices à la programation) et que Stephan code dans sa voiture (en tant que passager biensûr) :-).

Mon take-away de cette conférence : “I would rather have questions that can’t be answered than answers that are hallucinated” (“Je préfère avoir des questions auxquelles on ne peut répondre que des réponses hallucinées”) - une paraphrase de Stephan Janssen :-).

En voyant toutes les difficultés à tester et évaluer les LLMs, que Stephan a très bien illustré et essayé d’adresser, j’ai pu faire un parallèle avec la difficulté de tester et évaluer la pertinence des moteurs de recherche. J’ai trouvé la conférence très intéressante et j’ai hâte de tester RAG Genie et Devoxx Genie.

Lien de la conférence : Mettre en place un RAG Open Source en 30 minutes

Pietro a pu presenter une nouvelle version de sa conférence, après l’avoir rodée quelques mois auparavant au meetup Search, Data & AI. Depuis le meetup Deep dive into OpenSearch (FR/EN) tenu en janvier, Pietro a du adapter sa conférence pour inclure les dernières nouveautés d’OpenSearch, notamment le RAG tool introduit dans la version 2.13 et disponible depuis le 2 avril.

Pietro a d’abord fait une très belle introduction expliquant avec humour les points faibles des LLMs et la nécéssité de mettre en place un système RAG. Il a presenté les grands principes d’une architecture RAG, expliqué avec des exemples parlants en quoi consiste la vectorisation et quelle était la différénce entre les vecteurs creux (sparse vectors) et vecteurs denses (dense vectors).

Ensuite, il a présenté les différentes étapes pour mettre en place un RAG Open Source en 30 minutes à l’aide d’OpenSearch. Il a fait une démonstration en direct, montrant comment créer un RAG et l’utiliser pour répondre à des questions. La conclusion était que les technologies évoluent très vite, les moteurs de recherche intégrant de plus en plus de fonctionnalités de Retrieval Augmented Generation, les fonctionnalités vector search et hybrid search étant à ce stade très matures.

Lien de la conférence : La fin des mots de passes partagés avec Vault et Boundary

Premièrement le duo de speakers était très dynamique et a su captiver son audience. La conférence était très bien structurée, avec une introduction claire, des exemples concrets et des démonstrations en direct. Beaucoup de questions étaient posées par le public à la fin de la présentation, et les discussions était intéressantes.

J’ai participé à cette conférence car j'étais curieux de savoir comment des outils externes permettent d’améliorer l’accès sécurisé à des systèmes divers et varies comme des bases de données, des serveurs ou des applications. J’ai eu finalement ma réponse et je suis très content d’avoir choisi ce talk.

L’approche de Boundary est de se positionner en tant qu’intermédiaire (proxy) d’accès. Chaque connecteur posède des scripts pour créer des comptes utilisateurs ephémers et des tokens d’accès. Chaque connecteur a la connaissance du système sous-jacent et les scripts peuvent mettre en place différents niveau d’accès (administrateur, read-only, etc.). Afin de renforcer le côté ephemère des comptes utilisateurs, chauque script de création a un équivalent pour la suppressoin et Boundary permet de définir des politiques de durée de vie des comptes et des tokens.

Lien de la conférence : Construire son Assistant Intelligent avec Hugging Face et Elasticsearch

Notre atelier a été retenu par le comité de sélection de Devoxx France 2024 et j’ai eu l’honeur de l’animer avec Pietro Mele. Après avoir présenté une première version à Devoxx UK il y a presque un an mais dans un format beaucoup plus court (20 minutes), puis à Voxxed Days Luxembourg ensuite à DevFest Toulouse en format conférence (40-50 minutes), nous voici dotés de 3 heures pour transformer cette conférence en atelier Deep Dive.

Nous avons adapté notre conférence à Devoxx France et l’avons enrichi avec de nouveaux chapitres : les détails d’implémentation du Question Answering dans les moteurs de recherche, le traitement de la voix et un chapitre sur la génération augmentée par récupération (ou RAG - Retrieval Augmented Generation). Nous avons alterné théorie et pratique et ponctué l’atelier de sondages afin de le rendre le plus intéractif possible.

Lors de notre conférence, nous avons exploré comment utiliser Elasticsearch et Hugging Face pour créer un assistant intelligent personnalisé. Nous avons utilisé les modèles pour le traitement du langage naturel (NLP), les modèles LLM open source et l’indexation et la recherche vectorielle. Elasticsearch, moteur de recherche avancé et base de données NoSQL, nous a permis d’indexer et d’analyser des données de manière efficace, tandis que Hugging Face nous a offert une plateforme collaborative pour le développement et le déploiement de modèles de machine learning open source.

Au cours de notre session, nous avons approfondi la manière d’intégrer ces deux technologies pour construire des assistants intelligents sur mesure. Nous avons partagé des exemples concrets et des prototypes, en mettant l’accent sur les subtilités des modèles de langage naturel disponibles sur Hugging Face. Nous avons également revisité les fonctionnalités d’Elasticsearch et montré comment ces outils peuvent être combinés pour créer des versions personnalisées d’assistants intelligents comme ChatGPT.

Voici le déroulement complet de notre presentation :

Notre atelier a été un succès et nous avons reçu un retour très positif de la part du public (une note de 4,88/5 selon le système de feedback mis en place par les organisateurs sur le site du CFP). Nous sommes ravis d’avoir pu partager notre expérience et d’avoir contribué à l'échange de connaissances lors de cette édition de Devoxx France 2024.

Lien de l’atelier : Meet with an OSS project: LangChain4j

Je n’ai pas participé activement à cet atelier mais je tiens à féliciter les organisateurs pour avoir intégré ce format à la conférence. Plusieurs projets open source ont aisi pu avoir leur créneaux pour rassembler leurs communautés respectives. Proposé par Lize Raes de Open Tide, Julien Dubois et Antonio Goncalves de Microsoft et Cédric Lunven de DataStax, ce meetup a clairement été le plus populaire. J’ai croisé certains participants et organisateurs alors que nous nous préparions pour le meetup Search, Data & AI qui a eu lieu juste après, dans la même salle. Cette réunion a été très suivie, et LangChain4J a été probablement l’une des technologies les plus mentionnées pendant la conférence. Tout le monde semblait ravi de cette expérience.

Lien de l'évenement : Meetup Search Data and AI - Soirée Retrieval Augmented Generation (RAG)

Après avoir organisé deux éditions précédentes à Devoxx France, abordant respectivement les sujets des IA génératives et des moteurs de recherche du futur en 2023, ainsi que du langage Rust dans les moteurs de recherche en 2022, le Meetup Search, Data & AI était de retour cette année avec des démonstrations et des échanges sur le thème de la génération augmentée par récupération (RAG ou Retrieval Augmented Generation). Il est intéressant de noter que le terme RAG, qui a été largement abordé lors de Devoxx 2024, était déjà évoqué lors de notre précédente conférence sur l’IA générative et les moteurs de recherche du futur en 2023. A cette époque ce pattern d’architecture ne portait pas encore un nom :). Au vue de l’engoument que nous avons remarqué à Devoxx, nous sommes convaincus que 2024 sera l’année de la génération augmentée par récupération.

Nous avons eu une excellente participation de notre public, des échanges enrichissants et des présentations claires et impactantes de la part d’Aline Paponaud et Mouhcine Boutinzer.

En parallèle des différents meetups, une soirée Meet & Greet a été organisée, permettant aux participants de la conférence de rencontrer des collègues et les différents partenaires de la conférence. Pour ajouter une touche conviviale, un concert et un karaoké ont été animés par les développeurs les plus artistiques et festifs.

Lien vers la conférence : Interagir avec votre documentation technique via l’Intelligence Artificielle Générative

Le troisième jour a été particulièrement chargé pour l'équipe Adelean, avec la responsabilité d’animer trois ateliers. Le premier était un Lunch Talk, un format de présentation court de 15 minutes qui demande une préparation supplémentaire pour être concis, clair et exhaustif sur le sujet abordé.

L’objet de la conférence était de montrer comment l’intelligence artificielle générative révolutionne l’accès à la documentation technique. L'équipe a démontré comment transformer des documents techniques standards en systèmes conversationnels interactifs, offrant non seulement du code, mais aussi des explications pertinentes et adaptées aux besoins des utilisateurs. L’objectif était de simplifier la recherche d’informations et d’enrichir l’expérience de développement en rendant la documentation plus interactive et personnalisée.

Mouhcine a présenté plusieurs cas d’utilisation de moteurs de recherche conversationnels implémentés dans all.site, notre moteur de recherche collaboratif. Le premier cas d’utilisation portait sur la documentation d’Apache Solr, qui est dispersée sur différentes plateformes en fonction de la version de Solr : des fichiers PDF pour les versions 5 et avant, un site web Apache Lucene / Solr pour les versions 6 à 8 ainsi que le tout nouveau site de Solr 9. Par ailleurs, le Wiki et surtout les différents forums de discussions Slack complémentent la documentation accéssible en ligne. Mouhcine a montré comment enrichir la documentation en ligne avec du code et des ressources disponibles uniquement en local afin de la rendre plus facile d’accès et complète.

Le deuxième cas d’utilisation a mis en évidence un des points faibles des grands modèles linguistiques (LLMs) et systèmes conversationnels comme ChatGPT. En effet, les technologies developpées et mises en ligne après l’entraînement du modèle, sont moins bien supportées. Mouhcine a donné un exemple concrèt en utilisant la technologie LangChain4J qui est suffisament récente pour ne pas être connue notamment par Chat GPT. En indexant la documentation en ligne et le code de LangChain4J disponible sur GitHub dans all.site, nous obtenons des meilleurs réponses à des questions très précises sur la documentation et le code.

Notre conférence a été l’une des plus suivies lors des Lunch Talks, avec plus de 500 requêtes de mise en favoris. Mouhcine a réussi à respecter le timing tout en présentant la plupart des cas d’utilisation préparés en direct, sans utiliser nos vidéos de secours.

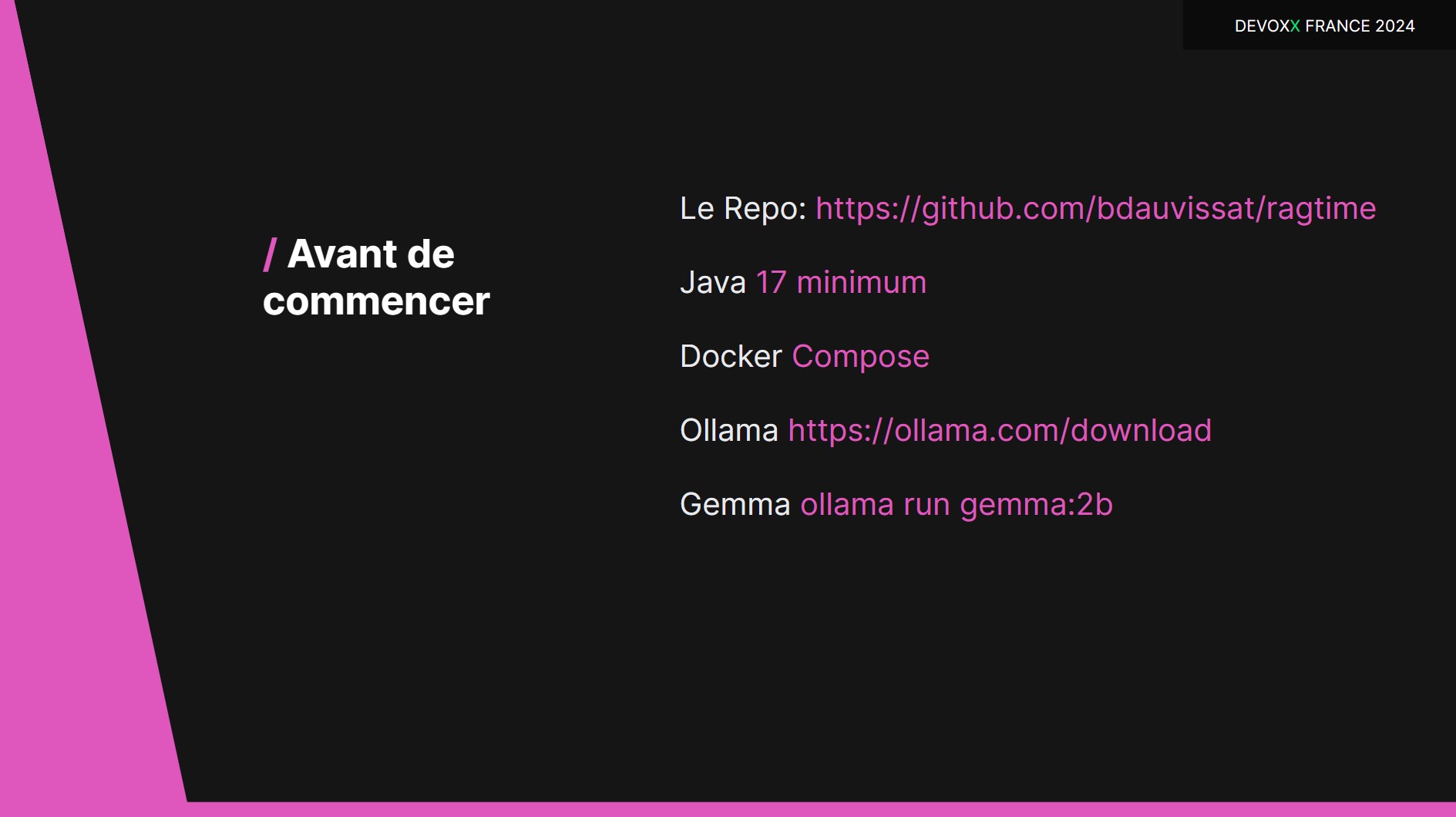

Lien vers la conférence : RAGtime : Discuter avec vos propres données

Nous avons eu le plaisir de proposer une formation spécialisée organisée par nos collègues Benjamin Dauvissat, Aline Paponaud, et Vincent Brehin de chez Adelean, en collaboration avec Sylvain Wallez d’Elastic. Cet atelier fut un succès, et nous sommes ravis de cette collaboration fructueuse.

L’atelier s’est concentré sur la construction d’un moteur de recherche conversationnel, aussi appelé “chatbot”, capable de travailler avec des données et documents privés. Pour ce faire, nous avons utilisé le concept du Retrieval Augmented Generation (RAG), qui permet de générer des réponses basées sur un contexte vérifiable. Elastic, réputé pour ses recherches par mots-clés, a enrichi ses fonctionnalités avec l’intégration des “dense vectors” et la recherche sémantique, facilitant une approche hybride. Parallèlement, l’intégration des Large Language Models (LLM) a été facilitée par des outils comme LangChain4J et des plateformes comme Ollama.

Au cours de ce hands-on lab, après une introduction théorique, les participants ont eu l’opportunité de développer un chatbot utilisant un jeu de données d’entreprise avec des outils tels qu’Elasticsearch, Quarkus, LangChain4J, et Ollama, et de tester en direct leurs créations.

L’ambiance était dynamique et l’atelier a démaré avec une chanson générée par l’IA avec un prompt d’Aline sur les vers écrits par Benjamin, une jolie poésie en lien avec le sujet très technique de la presentation. Car oui, Devoxx France est avant tout un lieu de fête :-).

Nous tenons à remercier chaleureusement Benjamin Dauvissat pour sa démonstration impressionnante de livecoding, Vincent Brehin pour ses contributions enrichissantes, Aline pour avoir su créer une ambiance captivante, et Sylvain pour ses conseils avisés et pour avoir partagé jusqu'à même son matériel et infrastructure, essentiels à la réussite de cet atelier.

Bien que cet atelier n’ait pas été enregistré, les ressources sont disponibles sur le repository GitHub et certaines présentations ont été partagées par les formateurs. Pour ceux intéressés à approfondir le sujet, nous proposons une formation complémentaire intitulée Libérer le potentiel des moteurs de recherche avec le RAG.

Lien vers la conférence : Apache Lucene : de l’indexation textuelle à l’intelligence artificielle

Notre conférence sur les fonctionnalités et l’histoire d’Apache Lucene, programmée en clôture de l'événement, a marqué la cinquième et dernière session organisée par Adelean. Cette présentation a clôturé en douceur trois jours intenses, couronnant également les semaines de préparation précédant Devoxx. Malgré la fatigue accumulée et l’approche du week-end, l’audience était présente en nombre. Nous avons adapté la présentation pour la rendre moins technique et plus accessible, afin de mieux répondre aux attentes du public.

Apache Lucene, qui a célébré son vingt-deuxième anniversaire en septembre, continue d’avoir un impact significatif dans le monde des technologies de recherche et de gestion de données. Ce moteur est la force sous-jacente de plateformes majeures telles qu’Elasticsearch, OpenSearch, Apache Solr, ainsi que le récent Atlas Search de MongoDB. Son intégration dans une variété de projets open source, comme Apache Nutch – un précurseur des web crawlers et d’Hadoop – et Apache Cassandra – la base de données NoSQL la plus scalable, illustre son influence considérable. Utilisé dans des milliers de projets d’entreprise, y compris par des leaders du marché comme LinkedIn et Twitter, Lucene jouit d’une base d’utilisateurs solide et diversifiée.

La conférence a exploré l'évolution de Lucene, depuis son mécanisme d’index inversé essentiel pour le traitement de texte jusqu’aux innovations les plus récentes qui marquent une avancée technologique continue. Pour finir, nous avons examiné les dernières fonctionnalités de Lucene : l’indexation des vecteurs et la recherche vectorielle, qui s’intègrent parfaitement à l’intelligence artificielle générative, ouvrant de nouvelles perspectives pour l’avenir de la recherche de données.

Bien occupé avec cinq ateliers et un meetup à orchestrer, mon emploi du temps lors de Devoxx était plutôt serré grâce à l'équipe Adelean. Les ajustements de dernière minute et les préparatifs ont naturellement pris du temps. Alors que plusieurs conférences m’aient tenté, je prévois de les visionner ultérieurement en vidéo.

Devoxx France a été une expérience intense et enrichissante. Cette conférence a non seulement servi de plateforme pour nous réunir en tant qu'équipe, mais aussi pour échanger avec des collègues d’Adelean et d’autres participants. Après des semaines de préparation minutieuse, nous espérons avoir répondu aux attentes. Cette édition était particulièrement axée sur l’intelligence artificielle, couvrant des thèmes comme les LLMs, RAG, LangChain, et l’IA générative. Nous sommes fiers d’avoir été parmi les pionniers de ces sujets dès l’année dernière lors du Meetup Search & Data à Devoxx et nous sommes ravis de la réception enthousiaste de nos présentations cette année. Merci à tous les participants pour leur engagement.

L’occasion nous a également permis de rencontrer d’anciens collègues, des clients et des partenaires, générant des discussions stimulantes et de nombreux moments agréables.

L’organisation de la conférence était impeccable, avec une programmation de haute qualité et des intervenants exceptionnels. Les bénévoles en gilets rouges ont réalisé un travail remarquable, contribuant au succès de cette édition élargie de Devoxx France, qui se positionne comme un événement technologique majeur pour les développeurs en France.

Notre expérience à Devoxx a été extrêmement positive. Nous avons partagé nos connaissances et notre expertise tout en apprenant énormément de la communauté. Inspirés, nous sommes impatients d’intégrer ces nouvelles idées dans nos projets futurs.

Nous tenons à exprimer notre gratitude envers les organisateurs, le comité de sélection, les partenaires et tous ceux qui ont contribué à la réussite de cet événement.